L'intelligence artificielle n'est pourtant pas de la magie

9 janvier 2021 (modifié le 14 janvier 2021)

On parle beaucoup d’intelligence artificielle en ce moment. Certainement, les résultats de la reconnaissance de formes (qu’elle soit de visages de personnes ou vocale) sont impressionnants. Mais il n’y a pas de quoi faire des envolées mystiques.

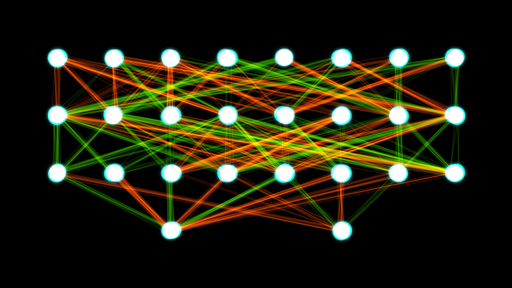

Qu’est-ce qu’un « réseau de neurones » ?

On oublie que les résultats obtenus dans le domaine de l’automatisation sont surtout le produit d’une technique particulière appelée réseaux de neurones. Celle-ci n’est pas du tout intelligente, au sens où nous l’entendons. Au contraire, elle réplique les mécanismes des êtres les plus primitifs du règne animal: des unicellulaires aux insectes et aux amphibiens.

Les réseaux de neurones qu’on trouve dans certains automatismes, sont des systèmes composés de nombreuses cellules, dont chacune est individuellement simple. Chacune récolte des signaux d’entrée de cellules adjacentes, et émet des nouveaux signaux de sortie, en fonction des signaux d’entrée et de son état présent. Les cellules sont généralement organisées en « couches » : les cellules d’une « couche » sont activées par la précédente et vont activer la « couche » suivante, et ainsi de suite: l’information se « propage » ainsi comme une onde.

Ces « cellules » n’existent bien entendu pas physiquement. Comme nos microprocesseurs (les unités de calcul) sont des « puces » ils simulent l’existence de ces cellules en tant que données.

Il est important de comprendre que ces systèmes artificiels de cellules ne « pensent » pas; il n’ont aucune compréhension de quoi que ce soit. Ils travaillent uniquement par identification à des impressions qu’ils ont déjà reçues.

Prenons un exemple simple: on montre à ces cellules quelques images de « chats », et on leur dit que quand elles voient quelque chose qui ressemble à « ça », elles doivent répondre « chat ». On leur montre ensuite des images de chiens et on leur dit que quand elles voient quelque chose qui ressemble, elles doivent répondre « chien ». Enfin, on leur montre des autres images pour leur dire que ces images ne sont pas intéressantes : elles doivent répondre « rien du tout ». Et le système s’ajuste par rapport à ces stimuli. Dorénavant, quand on présentera une nouvelle image à cette machine, elle essaiera de tout ramener à « chien », « chat » ou « rien du tout ».

On pourra ensuite attacher à ces « modèles », des actions à effectuer, en fonction de l’intensité des stimulus. Par exemple, accélérer une voiture, la freiner, la faire tourner.

On l’a compris, ces réseaux de neurones sont des servo-mécanismes, (le mot « servo- » signifie qu’ils sont asservis aux stimulus qu’ils reçoivent1). Ils « apprennent » uniquement au sens qu’ils enregistrent des stimuli et leur associent des réponses obligatoires; c’est ce qu’on appelle du conditionnement.

Quand les systèmes sont compliqués (c’est-à-dire formés d’un grand nombre de « couches »), on dit qu’ils sont « profonds », d’où le terme « deep learning ».

Avertissement: attention à l’anthropomorphisme

Intelligence artificielle, apprentissage, deep learning, ce sont des grands mots qui sonnent bien, mais qui évoquent des métaphores qui ne correspondent pas à la réalité.

Le conditionnement d’un réseau de neurones artificiels n’est pas de l’apprentissage au sens humain, qui impliquerait au contraire le développement d’une autonomie par rapport aux données.

En particulier, il n’y a évidemment aucune « profondeur » morale dans les réseaux de neurones2. C’est nous, les êtres humains, qui nous plaisons à y placer quelque chose de nous-mêmes qui n’y est pas. C’est ce qu’on appelle de l’anthropomorphisme3.

C’est tout à fait sain, tant qu’on reste conscient que c’est un acte d’imagination. Mais dès que quelqu’un commence à confondre son imagination avec la réalité matérielle, on est face à un trouble cognitif.

On arrive néanmoins à faire, avec l’intelligence artificielle, des choses « étonnantes » par rapport au niveau technologique de notre société – au point qu’on peut faire des systèmes qui reconnaissent des gens sur de caméras, ou des avions qui se pilotent en partie tous seuls.

De la technologie à la magie…

Pour ceux qui ont conduit une voiture Tesla (ou plutôt qui l’ont laissée se conduire sur l’autoroute), c’est assez formidable. Assurément; mais une fois l’émotion de la nouveauté passée, il faut remettre les pieds par terre.

tesla.com

Model S is built for speed and range, with beyond ludicrous acceleration, unparalleled performance and a refined design.

Toute technologie suffisamment avancée…

L’écrivain Arthur C. Clarke avait formulé une loi toute technologie suffisamment avancée est indiscernable de la magie4.

Le terme « suffisamment avancé » devrait nous alerter sur le fait que le sentiment de magie par rapport à la technologie n’est qu’une question relative; ou plutôt une question de perception (subjective), et non de réalité substantielle (objective).

La roue et le cheval de selle furent, au moins de leur apparition, deux technologies extrêmement avancées qui durent paraître réellement magiques pour les témoins.

De même, les premiers dirigeables, ou les premiers avions, la radio, la télévision, etc. durent paraître « magiques » à ceux qui les voyaient pour la première fois. Pour ceux qui voient une Tesla pour la première fois, ou pour ceux qui ne savent pas comment elle se dirige, il est probable que tout cela est de la « magie ».

Regardez une télécommande de téléviseur, ou un smartphone avec un programme de télécommande quelconque, et vous verrez que tout cela n’est pas très éloigné d’une « baguette magique ». Songez-y: vous dirigez votre « baguette » vers un objet et pouf ! quelque chose se produit à distance.

Les invocations magiques…

« Hé Laisse Moins Ailes, Ah! »

Les instructions routinières qu’un informaticien donne à sa machine, ne ressemblent-elles pas à des invocations magiques ou mystiques, toutes emplies d’une poésie étrange… qui rappelle le « Treguna mekoidis, trecorum, satis dee » du film L’apprentie sorcière de Walt Disney?

Peut-être; jusqu’à ce qu’on réalise que l’informaticien avait prosaïquement tapé sur son clavier:

ls -la

Ce qui veut dire: « fais moi une liste détaillée de tous les documents dans ce dossier, y-compris les sous-dossiers et documents cachés ».

Bien que cela perd incontestablement de son charme mystérieux, cela gagne beaucoup en efficacité…

L’identification automatique n’est pas de « l’intelligence »

Ce qui est inquiétant à propos de la soi-disant intelligence artificielle, c’est les discours extasiés autour d’elle, tenus par des personnes qui sont pourtant des universitaires et qui devraient percevoir nettement la différence entre la science et des débordements de l’imagination.

À l’origine du terme intelligence artificielle, il y a une confusion grave qui naît d’une profonde méprise à propos de la définition de l’intelligence. Et probablement, une identification confuse (et peut-être inconsciente) entre les réseaux de neurones artificiels, et l’intelligence de l’être humain, au-travers les neurones du cerveau (sous-entendu: si l’on comprend les neurones du cerveau, alors aura compris toute l’intelligence humaine).

Le syllogisme est à peu près le suivant:

- Les automatismes informatiques sont souvent fondés sur des réseau de neurones composés de cellules.

- Un être humain possède un cerveau formé de cellules

- Donc ces automatismes sont pareils à la conscience de l’être humain et on va les appeler « intelligence artificielle ».

Ces approximations forment une belle salade conceptuelle, qui semble reposer surtout sur des opinions, des extrapolations, et des professions de foi. Si on y regarde de plus près, on trouve une vision Pavlovienne floue de l’être humain, vu comme un chien glorifié, qui ne saurait que saliver sur la base de stimuli. Et pourtant un chien, (en tout cas à notre connaissance), ne sait pas faire de la poésie, peindre la Joconde, ou élaborer des théories d’astrophysique.

Qu’est-ce que l’intelligence ?

Le dictionnaire TLFi donne une définition assez lumineuse de l’intelligence: fonction mentale d’organisation du réel en pensées, en l’opposant l’être humain au monde animal.

L’intelligence humaine n’a donc rien à voir avec avec la capacité d’identifier un chat réel avec un chat donné en modèle.

L’action d’identifier n’est pas de l’organisation en soi, mais justement une forme de pensée inférieure, dépourvue d’organisation, qui fonctionne par excitation-réflexe (ou conditionnement si l’on préfère).

L’intelligence humaine est très différente de cela: non seulement elle identifie des objects entre eux, mais elle sait aussi de concevoir des différences, qui lui permettent justement d’établir des classifications.

Il y a donc un gouffre entre une machine qui compose des textes qui ne sont qu’une juxtaposition plausible de mots (aussi plaisants qu’ils soient), et la création d’un texte original par un être humain, qui soit le fruit d’une démarche conceptuelle.

En somme, un réseau de neurones artificiel ne sait pas concevoir des différences. Il ne procède (systématiquement) que par identification (ramener quelque chose de nouveau à quelque chose de déjà connu). Chaque paquet de stimulus envoyé dans le système ramène à un objet à reconnaître; s’il faut choisir entre plusieurs objets, alors le mécanisme choisira en quelque sorte « le chemin le plus court » vers l’objet qui « ressemble le plus ».

L’intelligence supposerait une capacité tout à fait différente: de construire le réel, de prendre du recul, de réordonner l’existant en concepts abstraits, non pas en fonction de modèles préexistants, mais de nouveaux modèles.

L’intelligence se manifeste notamment dans la construction des modèles. Ces nouveaux modèles ne sont pas le fruit du hasard, mais d’un processus de pensée qu’on ne peut pas (dans l’état de nos connaissances) réaliser avec un réseau de neurones.

Ceux qui pensent qu’il possible de réaliser des automates qui se rapprochent de cet idéal sont en droit de le faire. Mais le fait est qu’aujourd’hui personne ne sait faire cela avec un algorithme neuronal, et il n’y a pas d’indications que ce soit même matériellement ou philosophiquement réalisable. Penser que cela soit à notre portée relève de la spéculation.

Et tout ingénieur vous dira qu’on ne construit pas de bonnes machines avec de vagues espérances ou du bric-à-brac mystique.

Un réseau de neurones ne pense pas, il réagit

La pensée que l’on associe à l’intelligence, est totalement absente d’un de ces mécanismes. Il ne fait que réagir. C’est une sorte de « boîte noire » incapable de prendre du recul, voire d’expliquer ses propres décisions.

Même un traducteur automatique comme DeepL, qui donne des résultats plutôt étonnants, est un servo-mécanisme dépourvu d’intelligence : il ne fait que manipuler des mots comme un vaste jeu de cartes. Un mot n’au aucun sens pour lui, sauf comme relation avec d’autres mots, des stimuli ou des actions.

Il pourra, certes, vous en donner la définition d’un mot au besoin. Mais à nouveau, cette définition n’est qu’une suite de symboles.

On pourra lui faire ordonner ces objets, mais cela sera toujours le même cercle vicieux : ce n’est qu’un sac de symboles liés entre eux de façon à constituer un automate excitation-réflexe.

deepl.com

Use the free DeepL Translator to translate your texts with the best machine translation available, powered by DeepLâs world-leading neural network technology. Currently supported languages are: Bulgarian, Chinese, Czech, Danish, Dutch, English, Estonian, Finnish, French, German, Greek, Hungarian, Italian, Japanese, Latvian, Lithuanian, Polish, Portuguese, Romanian, Russian, Slovak, Slovenian, Spanish, and Swedish.

Une Tesla: même pas « l’intelligence » d’une mouche ?

Où se trouve l’intelligence là-dedans, on se le demande ? La meilleure comparaison qu’on puisse faire d’une Tesla est une mouche.

Une voiture automatique reçoit des informations sur l’environnement de la route avec une vision à 360 degrés; comme une mouche. Elle réagit de façon adéquate aux obstacles ou aux menaces, en accélérant, en ralentissant, et/ou en changeant de direction. Elle adapte ses paramètres de fonctionnement, comme la température intérieure, la pression des fluides, etc.

La comparaison est limitée car une mouche est, en réalité, plus sophistiquée qu’une Tesla. En premier lieu, elle s’oriente en trois dimensions (elle vole), ce qui est bien plus complexe. Mais cela n’est qu’un aspect secondaire, à côté d’autres aspects: une mouche peut croître, s’auto-réparer, se reproduire. Cela veut dire la capacité de reconnaître une multiplicité de formes et de couleurs, et de réagir en conséquence. Chacun de ses deux yeux possède quelques milliers de facettes, qui envoient autant signaux qui doivent être constamment interprétés.

Une mouche est donc une mécanique remarquable, capable de prouesses techniques. Les calculs que son cerveau doit effectuer pour adapter les battements de ses ailes à la trajectoire requerraient une puissance de calcul et une précision de la mécanique de vol, qui est encore un peu au-delà de ce que nous savons faire: notre technologie commence tout juste à maîtriser le vol avec des ailes qui ne soient pas fixes (avions) ou tournantes (hélicoptères).

Et pourtant, en dépit de la merveille mécanique de la mouche, quelqu’un va-t-il affirmer qu’elle est « intelligente »?

Bien sûr que non. Une mouche n’a pas les attribut élémentaires qu’on associe à l’intelligence humaine. Elle ne peut pas raisonner au sens où nous le comprenons. Demandez-lui de vous expliquer comment elle vole, ou ce qu’est une fleur, et vous n’obtiendrez au mieux qu’un battement d’ailes.

Pourrait-elle vraiment vous révéler les équations complexes qui gouvernent son vol contrôlé? A-t-elle même la notion qu’elle vole ou d’une « fleur », ou n’est-ce pour elle que des couleurs et des formes ? Non, bien sûr: elle est « immédiate », c’est-à-dire qu’elle agit par excitation-réflexe, sans recul (sans conscience de soi ou de son propre fonctionnement), sans réfléchir. Son « autonomie » est toute relative.

La chimère de « l’intelligence artificielle »

Soulignons que rien de ce qui précède n’a pour but de diminuer le mérite de ceux qui ont assemblé une voiture qui se conduit toute seule, ou un programme de traduction automatique.

En réalité, il y a bel et bien une grande quantité d’intelligence dans ces réalisations, mais d’intelligence humaine. Et c’est là l’essentiel: ces servo-mécanismes avancés sont un témoignage de la compétence technologique et de l’imagination des ingénieurs, ainsi que de la capacité d’innovation des entreprises.

La noblesse du travail de l’ingénieur, se situe dans cette synthèse réussie entre l’imagination et le réalisme.

Tout à l’inverse, on trouve le péché d’irréalisme et de manque d’imagination, commis par la direction de l’Ecole Polytechnique fédérale de Laussanne (EPFL) avec le Human Brain Project du professseur Henry Markram. Cette initiative lancée en 2009 a été beaucoup critiqué, et de façon justifiée : s’auto-proclamant de « projet de neurosciences le plus ambitieux du monde », elle promettait « une cartographie qui englobe tous les niveaux d’organisation du cerveau, de la cellule individuelle jusqu’à l’ensemble du cerveau. »

On ne peut que rester stupéfaits devant l’ambition et l’irréalisme de cet objectif – et surtout que des universitaires se soient lancés dans la poursuite d’un tel miroir aux alouettes, qui s’éloigne fortement des traditions de solide ingéniérie de l’EPFL. Il est manifeste que les motivations de ce projet tenaient plutôt du prestige et du show business (afin de rassembler un maximum de subventions et de financements) que du souci de faire progresser la science de façon ordonnée. C’est ce qu’on appelle un vanity project, voire un éléphant blanc5.

Le réductionnisme de l’intelligence humaine à un réseau de neurones

On ne peut que regretter que des technologies prometteuses d’imagerie du cerveau, d’informatique et de mécanique qui auront incontestablement des applications positives pour la santé publique, soient subordonnées à des opinions réductrices sur l’être humain (voir des idéologies) qui tentent imprudemment de réduire l’intelligence humaine à un réseau de neurones.

C’est pire que du réductionnisme idéologique: c’est un acte d’impudence, une profession de foi étonnante, de la part d’universitaires qui devraient au contraire enseigner à leurs étudiants les exigences de réalité et d’humilité de toute démarche scientifique.

Sur la question du réductionnisme, voir aussi un billet de ce blog (4 janvier 2020) consacré à ce sujet.

Surtout, les responsables de ce projet extravagant causent un dommage considérable à notre culture, en faisant circuler ce qui n’est que leur propre thèse idéologique (non démontrée), en la faisant passer pour une certitude scientifique bien établie. Avec une tel objectif irréaliste, on est dans l’auto-aveuglement, voire du numéro d’illusioniste. Sans surprise, la nature réserve des déceptions cruelles aux téméraires qui se lancent dans des aventures qui sont en-dehors de leurs possibilités: les déboires du Brain Project (aujourd’hui renommés « Blue Brain Project », comme si les stimuli rassurants liés à cette couleur pouvaient y faire quelque chose) sont devenus une source d’embarras pour le monde académique suisse.6.

Mais pourquoi infliger des sentiments d’échec à des ingénieurs ?

« Qui trop embrasse, mal étreint. »

Il est regrettable que les succès probables que le projet ne pouvait qu’avoir dans les techniques de l’ingénieur (le techniques réelles, notamment dans le domaine du génie médical), seront toujours diminuées par l’échec que les participants auront forcément dans leur but chimérique de « tout comprendre » de l’être humain, au travers de l’imagerie de la structure du cerveau.

Si le professeur Markram avait eu l’humilité de tenter de reproduire le cerveau d’une mouche drosophile, ils n’aurait sans doute pas obtenu eu toute l’attention des médias et des organismes de financement public ou privé.

Mais si, au lieu de s’épuiser dans un exercice de show business, ce projet avait consacré tous ses efforts à une démarche de développement avec des objectifs atteignables, il aurait pu faire avancer l’ingéniérie (et le génie médical) bien au-delà de ce qu’il a fait jusqu’à présent.

Il est toujours dangereux, pour des ingénieurs, de susciter des attentes qui ne peuvent pas être raisonnablement remplies. Le sentiment d’échec et de déception est inévitable.

Conclusion

Quelle est la conclusion de ce discours ? Le fait que nos réalisations techniques sont extraordinaires. Mais que nos automates n’arrivent pas encore au niveau intellectuel de la mouche drosophile.

En ce qui concerne la réplication de l’intelligence humaine, notre technologie n’en est même pas à la case départ ! La vérité est que personne (à notre connaissance) ne sait faire cela.

L’intelligence artificielle est un terme impropre

Le jargon technique est plein de ces termes impropres (qui ne veulent pas dire ce qu’ils semblent dire); ils ne sont pas gênants, pourvu qu’on sache qu’ils sont impropres.

C’est le fait qu’une grande partie de la population, et malheureusement également une partie du monde académique, entretient des idées infondées (c’est à dire non démontrées et donc non-scientifiques) sur l’intelligence humaine, qui nous cause un problème grave avec l’intelligence artificielle.

Cette discipline si mal nommée de l’intelligence artificielle n’est pourtant pas fautive. Elle réunit, de nos jours des développeurs parmi les personnes (humaines) les plus intelligentes de la planète, qui repoussent chaque jour les limites de ce que l’humanité peut faire dans ce domaine.

Ce qui est en cause, c’est une vision réductrice de l’être humain à des cellules. Le danger réel pour la société se trouve dans la perception « magique » de cette technologie prometteuse; et notamment dans l’anthopomorphisme irrationnel typique du Brain Project à propos des machines automatiques, qui crée des attentes absurdes qui ne seront pas satisfaites – et des budgets de recherche/développement mal dépensés.

Cette erreur de pensée provoque, surtout, des angoisses inutiles dans la population, vis-à-vis d’automates somme toutes primitifs, qui ne sont même pas tout à fait comparables à des mouches.

Est-il logique de craindre que des mouches remplaceront l’homme ? Il faudrait se comporter de façon intelligente vis-à-vis de cette prétendue « intelligence artificielle » et se relaxer à son sujet. Le prof. Markram a échoué dans son entreprise de simuler l’intelligence humaine avec des ordinateurs, comme on pouvait s’y attendre. Les partisans de cette thèse téméraire risquent de rejoindre, dans leur déception, tous ceux qui avaient tenté pendant des siècles de résoudre la quadrature du cercle6.

Certes les machines vont remplacer l’être humain dans des tâches particulières (c’est bien pour cela qu’on les a créées). Mais ces créations artificielles resteront limitées, et fragiles; elles « tomberont en panne » dès qu’on les sort de leur contexte ou qu’on y introduit des éléments inattendus; elles ne sauront pas se réinventer constamment pour survivre, comme font quotidiennement les organismes vivants. Bien sûr: on pourra les améliorer, les rendre plus robustes, même auto-réparables dans une certaine mesure. Mais tous les efforts ne changeront rien à deux limitations intrinsèques : ces machines ne sont ni vivantes, ni intelligentes au sens humain.

Bien sûr, si certains universitaires veulent continuer de rêver de construire, dans un jour éloigné, des machines qui pourront approcher l’être humain dans ce qu’il y a de plus essentiel, à leur aise. L’espoir fait vivre.

Mais qu’ils ne viennent pas nous faire des discours politiques ou sociaux, à propos de ce qui reste aujourd’hui une chimère: ces automates ne sont pas près de remplacer la fonction de l’être humain dans notre écosystème aujourd’hui, pas plus qu’à l’époque de la Révolution industrielle. Ni dans un avenir prévisible.

Il est bien d’avoir la tête dans les étoiles, à condition de bien garder les pieds par terre.

Faites l’expérience par vous-même !

Ceux que le discours ci-dessus n’arrive pas à convaincre, devraient faire une expérience pratique, qui est à la portée d’écoliers du lycée : prenez un tout petit ordinateur à 50 euros, attachez-y une caméra à bon marché, et écrivez un programme qui permet de reconnaître les personnes qui rentrent dans une pièce de la maison. Cela contribuera, je l’espère, à démystifier ce sujet. Et paradoxalement, tout cela devient fascinant dès qu’on en a retiré tout le bric-à-brac mystico-magique.

raspberrypi.org

Add face recognition with Raspberry Pi | Hackspace 38 - Raspberry Pi

You can now use a <£50 computer to reliably recognise someone’s face with surprising accuracy. Here’s a beginner's guide to face recognition.

Autres billets

- Vous avez peur de l’IA? Apprenez à programmer

- « Education numérique » à Genève: discours vides et prétentieux

-

Asservir: Mettre sous la dépendance de; mettre dans l’obligation d’obéir à (appliqué à des choses concrètes, notamment des mécanismes) TLFi. ↩

-

Profondeur: « Caractère de ce qui est intense, durable, de ce qui, dans le domaine de la vie intérieure, atteint la personne au plus intime d’elle-même. » TLFi ↩

-

Anthropomorphisme: « Tendance à se représenter toute réalité comme semblable à la réalité humaine. » TLFi. ↩

-

Arthur Charles Clarke, Profiles of the Future: An Inquiry into the Limits of the Possible, 1962 ↩

-

« Eléphant blanc désigne une réalisation, un ouvrage de grande ampleur et de prestige, la plupart du temps initiée dans le domaine public, et qui s’avère plus onéreuse qu’utile et dont, finalement, l’existence devient un poids financièrement. » Dictionnaire l’internaute. ↩

-

Le défi de géométrie qui consiste à trouver, avec règle et compas, un carré ayant la même aire qu’un cercle. Le problème préocuppa les mathématiciens au moins depuis l’époque de la Grèce ancienne. Il fut démontré mathématiquement, vers la fin du XIXe siècle, que ce problème n’avait pas de solution. ↩↩